최근 구글의 Gemini 3가 발표되면서 구글의 기술력이 다시금 주목받고 주가에도 긍정적인 영향을 미치고 있습니다. 많은 사람들이 모델의 성능에 집중할 때, 저는 TPU 초기 모델부터 모니터링해 온 엔지니어로서 구글 인프라의 ‘심장’이라 할 수 있는 하드웨어 기술에 주목했습니다.

최근 구글의 Gemini 3가 발표되면서 구글의 기술력이 다시금 주목받고 주가에도 긍정적인 영향을 미치고 있습니다. 많은 사람들이 모델의 성능에 집중할 때, 저는 TPU 초기 모델부터 모니터링해 온 엔지니어로서 구글 인프라의 ‘심장’이라 할 수 있는 하드웨어 기술에 주목했습니다.

특히 TPUv4와 함께 공개된 OCS (Optical Circuit Switching, 광 회선 스위칭) 기술은 타 경쟁사들과 구글을 차별화하는 결정적인 ‘해자(Moat)‘이자, 처음 접했을 때 신선한 충격을 주었던 기술입니다.

오늘은 이 OCS 기술이 왜 혁신적인지, 그리고 클라우드 아키텍처 관점에서 어떤 의미를 갖는지 정리해 보려 합니다.

1. OCS란 무엇인가? (패킷이 아닌 ‘빛’을 쏘다)

OCS 기술의 핵심은 데이터센터 네트워킹의 패러다임을 바꾼 것에 있습니다. 보통 우리가 아는 네트워크 스위치는 전기로 작동합니다.

- 기존 방식 (Packet Switching): 광케이블로 온 신호를 전기로 변환(O-E) -> 패킷 주소 확인 및 스위칭 -> 다시 광신호로 변환(E-O)하여 전송.

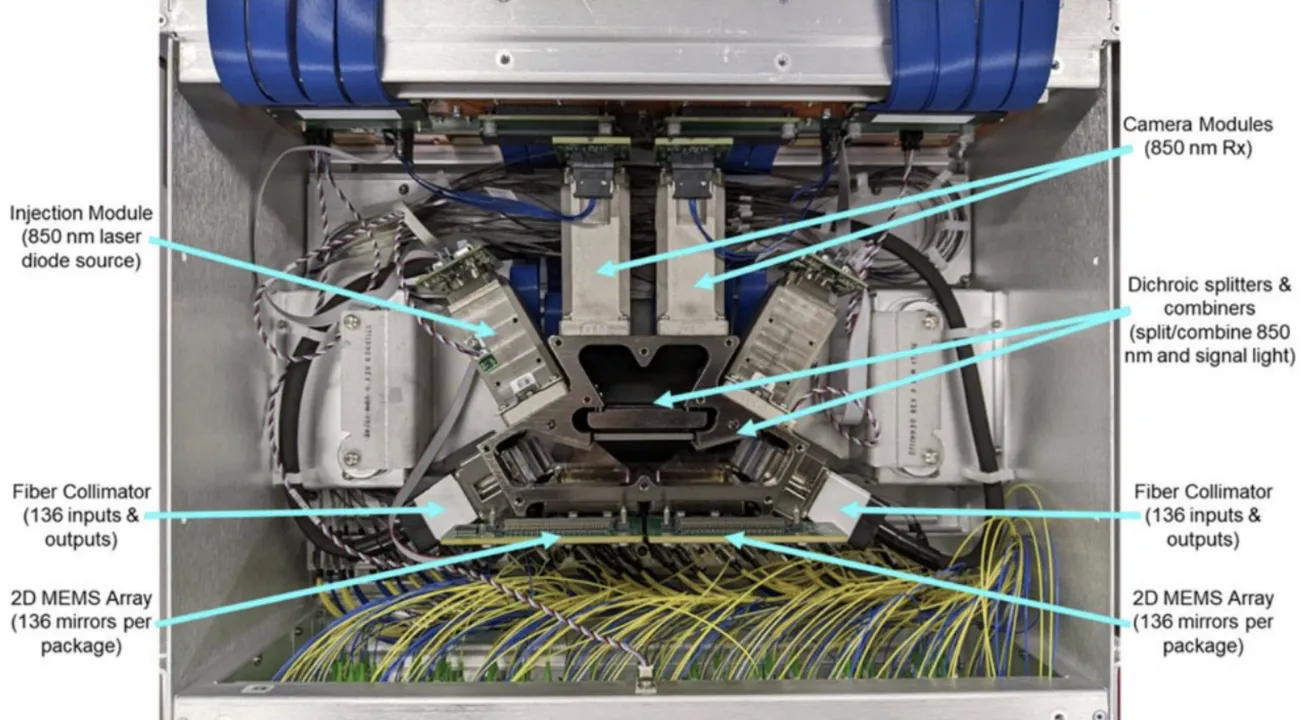

- 구글 OCS: 광케이블의 빛 신호를 변환 없이 MEMS(초소형 정밀 기계) 거울을 이용해 물리적으로 반사시켜 목적지로 보냄.

“인터넷 우체국” vs “옛날 전화 교환국”

이 차이를 쉽게 비유하자면 다음과 같습니다.

지금의 인터넷(이더넷)은 ‘우체국’과 같습니다. 모든 우편물(패킷)이 중앙 허브(스위치)로 모이고, 분류 작업을 거쳐 다시 각지로 뿌려집니다. 유연하지만 물량이 폭주하면 중앙 허브에서 병목이 발생합니다.

반면 구글의 OCS는 ‘옛날 전화 교환국’과 비슷합니다. A가 B에게 전화를 걸고 싶다고 하면, 교환원이 물리적으로 선을 꽂아 둘을 직접 연결해 버립니다(Circuit Switching). 중간에 패킷을 까보는 과정이 없으니, 데이터 처리량(Throughput)이 아무리 늘어나도 스위치 단에서의 병목이 ‘0’이 됩니다. 물론 연결된 동안 다른 곳으로 데이터를 못 보낸다는 단점이 있지만, 구글은 이를 기가 막힌 방법으로 해결했습니다.

2. 구글의 역발상: AI 워크로드의 본질을 꿰뚫다

처음에는 “이 디지털 시대에 회선 스위칭이라니, 시대를 역행하는 것 아닌가?“라는 생각도 들었습니다. 하지만 구글이 공개한 논문을 보면 그들의 통찰력에 무릎을 치게 됩니다.

구글은 AI(NPU) 워크로드를 분석한 결과, “대부분의 연결 패턴은 고정적이다”라는 사실을 발견했습니다. 대규모 학습 시에는 수천 개의 TPU가 촘촘히 연결되어야 하지만, 일단 학습이 시작되면 데이터가 흐르는 길은 한동안 바뀌지 않습니다. 즉, 매 패킷마다 경로를 고민해야 하는 라우터 방식은 낭비라는 것이죠.

압도적인 규모와 성능

이 OCS 기술을 기반으로 구축된 TPUv4 Pod의 스펙은 경이롭습니다.

- 규모: 단일 Pod에 4,096개의 TPUv4 칩 연결

- 성능: 단일 시스템에서 1 엑사플롭(ExaFLOP) 이상의 연산 능력

- 연결: 4,096개 칩이 256TB의 HBM을 마치 하나의 메모리처럼 공유

3. 소프트웨어 정의 토폴로지 (Software-Defined Topology)

OCS의 가장 큰 장점은 “물리적 배선을 소프트웨어로 바꾼다”는 점입니다. 사람이 케이블을 다시 꽂을 필요 없이, 소프트웨어 명령만으로 수천 개 칩의 연결 구조(토폴로지)를 0.001초(ms) 단위로 바꿀 수 있습니다.

- Twisted Torus: 구글은 이를 이용해 일반적인 도넛 모양 연결(Torus)보다 대역폭 효율이 훨씬 높은 ‘비틀린 토러스’ 구조를 구현했습니다.

- 기술적 디테일: 구글은 광케이블의 정렬(Alignment) 문제를 해결하기 위해 Dichroic Splitter(이색성 빔 스플리터)와 별도의 정렬용 레이저를 사용하는 고도의 기술을 적용했습니다.

이 덕분에 LLM 학습이냐, 추천 모델이냐에 따라 최적의 네트워크 모양으로 변신할 수 있습니다. 예를 들어, 추천 모델을 위해 임베딩 연산을 가속하는 SparseCore를 활용할 때와 거대 언어 모델(PaLM)을 학습할 때의 네트워크 구조를 다르게 가져가는 것입니다.

4. 클라우드 엔지니어로서의 고찰: 왜 이 기술이 탐나는가?

저는 AWS나 여러 클라우드 서비스를 사용하면서 늘 ‘스위치 병목’에 대한 아쉬움이 있었습니다. 보통 클라우드 아키텍처는 컴퓨팅(CPU) 영역과 스토리지(저장) 영역을 분리합니다.

어플리케이션이 동작하려면 CPU가 스토리지에 수시로 접근해야 하는데, 이 트래픽이 모두 중앙화된 네트워크 스위치를 거쳐야 합니다. 가상 머신(VM)이 늘어날수록 스위치는 엄청난 부하를 견뎌야 하고, 여기서 레이턴시와 발열, 전력 소모 문제가 발생합니다.

하지만 구글의 OCS 방식을 적용하면? 서버와 스토리지를 다이렉트(Direct)로 연결해 버릴 수 있습니다. 아무리 많은 가상 환경이 떠 있어도 물리적으로 뚫린 전용 도로를 쓰기 때문에 간섭 없이 서비스를 할 수 있는 것입니다.

타 기술과의 격차

물론 전기적 스위칭(Electrical Circuit Switching)을 시도하는 곳들도 있습니다. 하지만 구글의 광(Optical) 방식과 비교하면 단점이 명확합니다.

- 속도: 설정 변경 속도가 느림

- 효율: 전력 소모가 크고 신호 손실 발생

- 확장성: 한 번에 처리 가능한 회선 수가 적음 (구글 OCS는 단일 모듈에서 136개 포트 동시 처리)

5. 마치며

구글은 이 OCS 기술을 자체 개발 및 전략적인 인수합병을 통해 확보하고 내재화했습니다. (마치 칩 설계부터 데이터센터 냉각까지 수직 계열화한 것처럼 말이죠.)

지금처럼 AI 모델이 거대해지고 데이터 전송량이 폭발하는 시대에, ‘빛을 거울로 반사해서 연결한다’는 이 단순하고도 강력한 물리적 기술은 소프트웨어 최적화만으로는 결코 넘을 수 없는 벽을 만듭니다.

Gemini의 성능 뒤에는 이런 무시무시한 인프라가 버티고 있습니다. 클라우드와 AI 인프라를 다루는 입장에서, 솔직히 저희 회사에도 도입하고 싶을 만큼 탐나는 기술입니다. 이것이 바로 구글이 AI 전쟁에서 가진 진짜 ‘히든카드’가 아닐까 생각합니다.